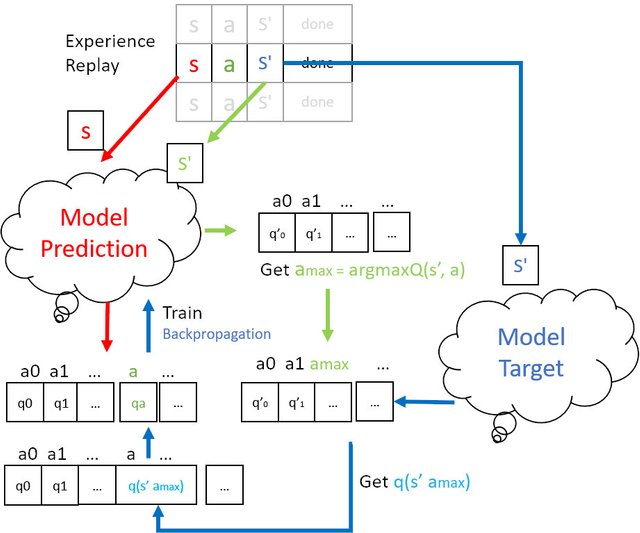

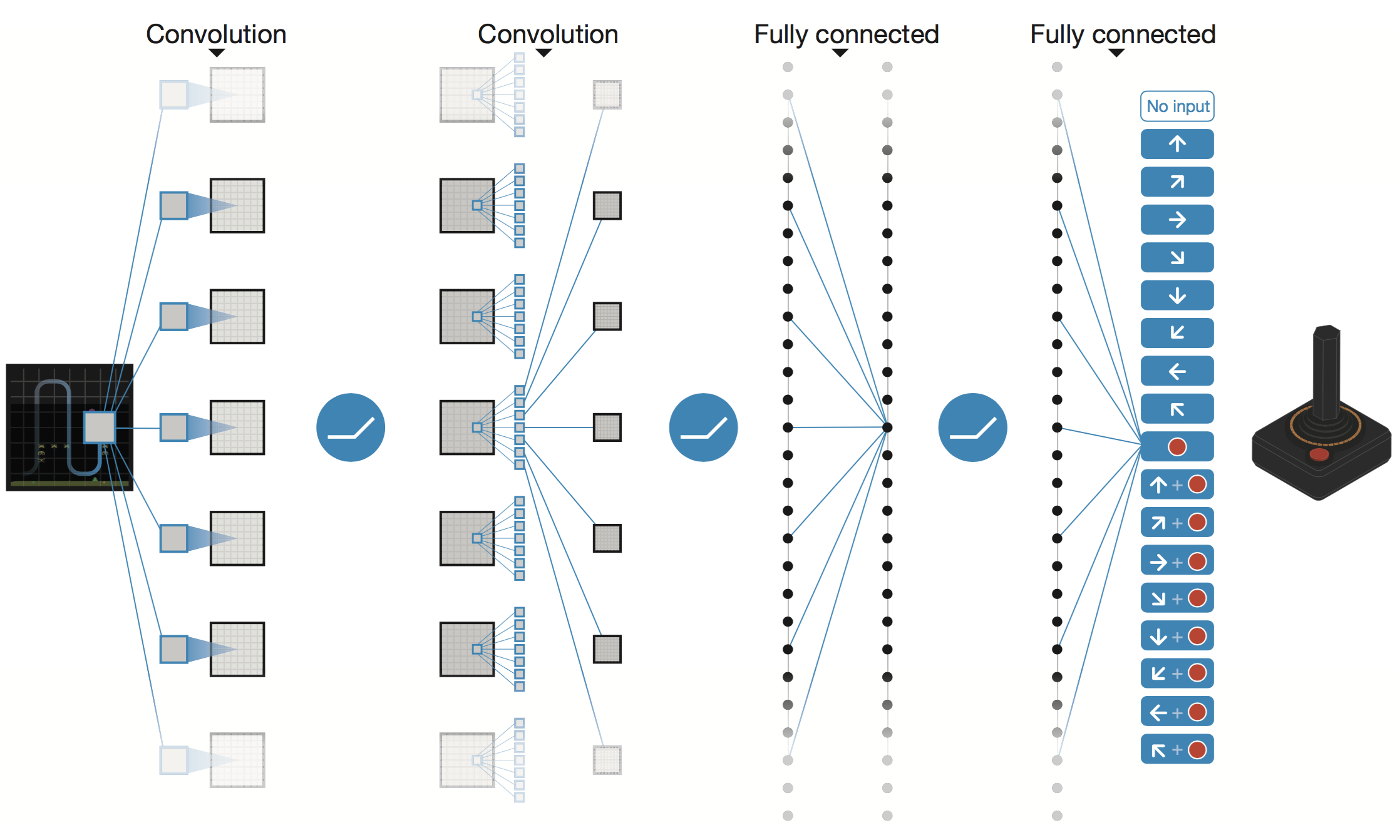

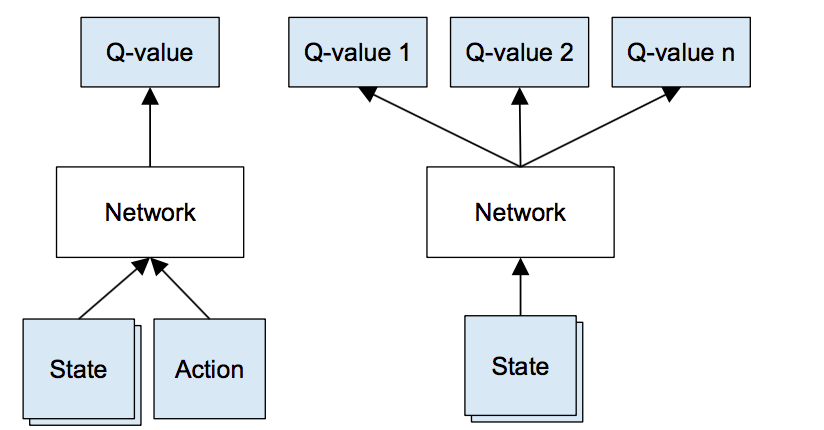

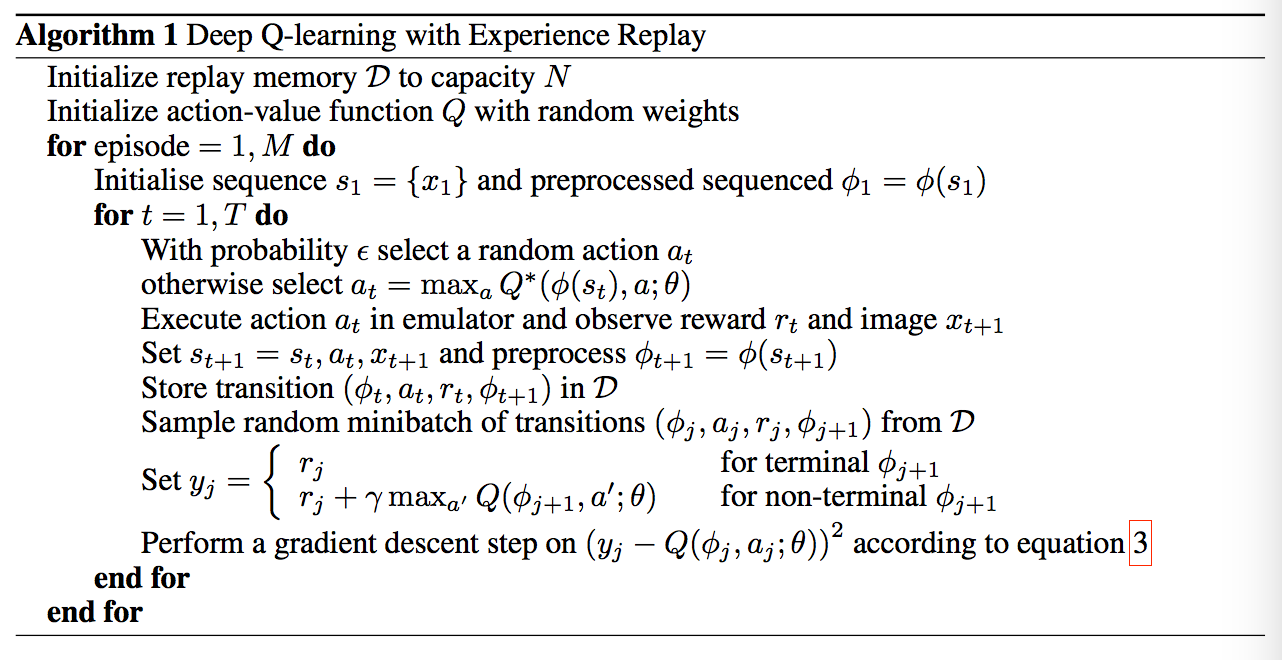

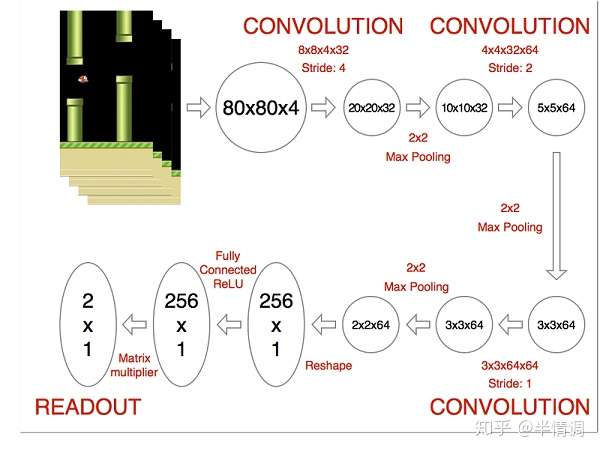

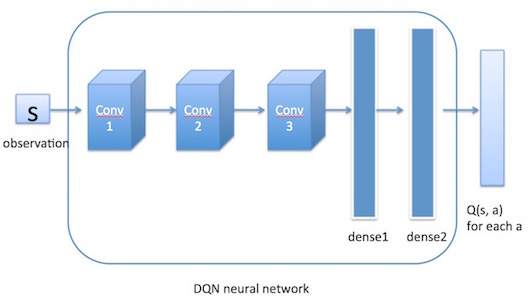

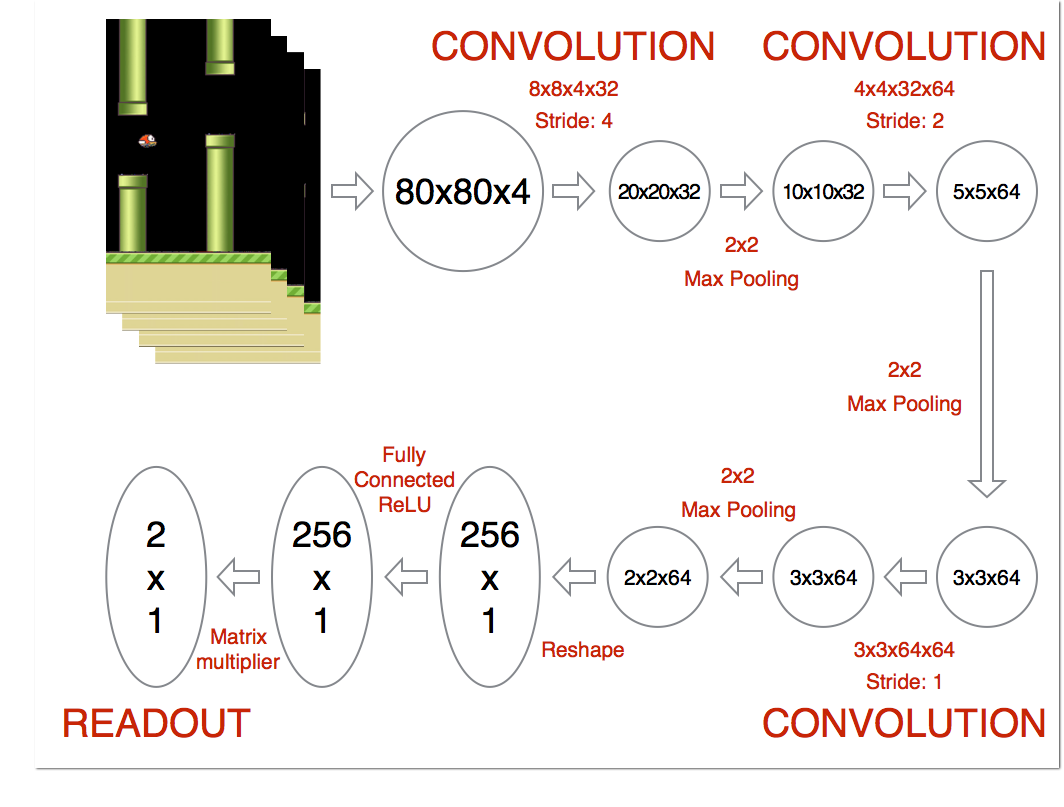

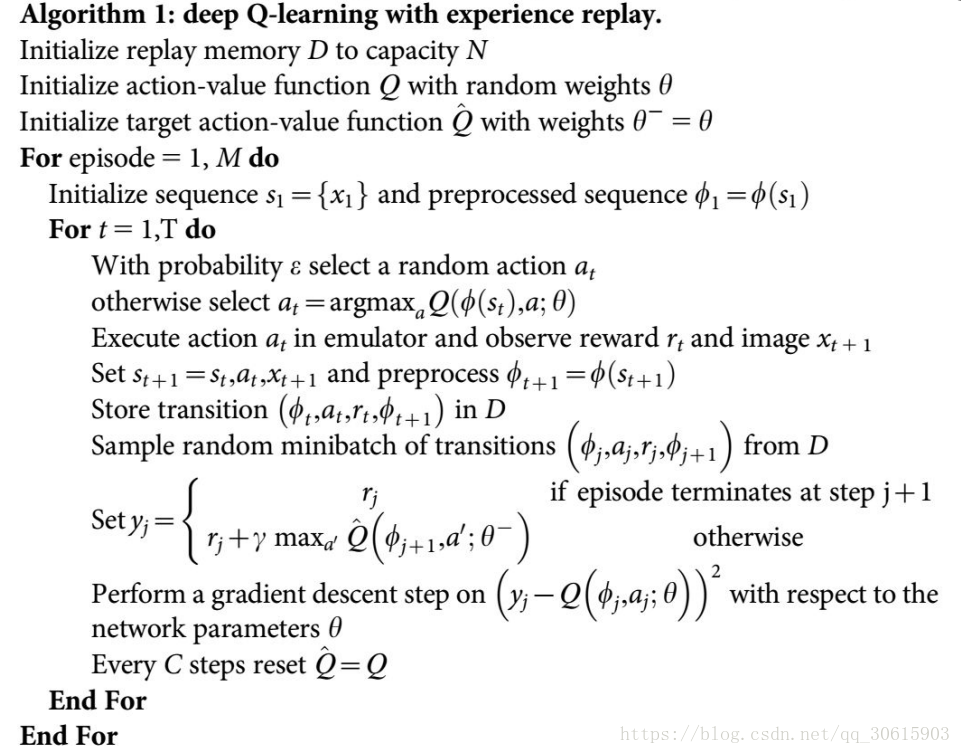

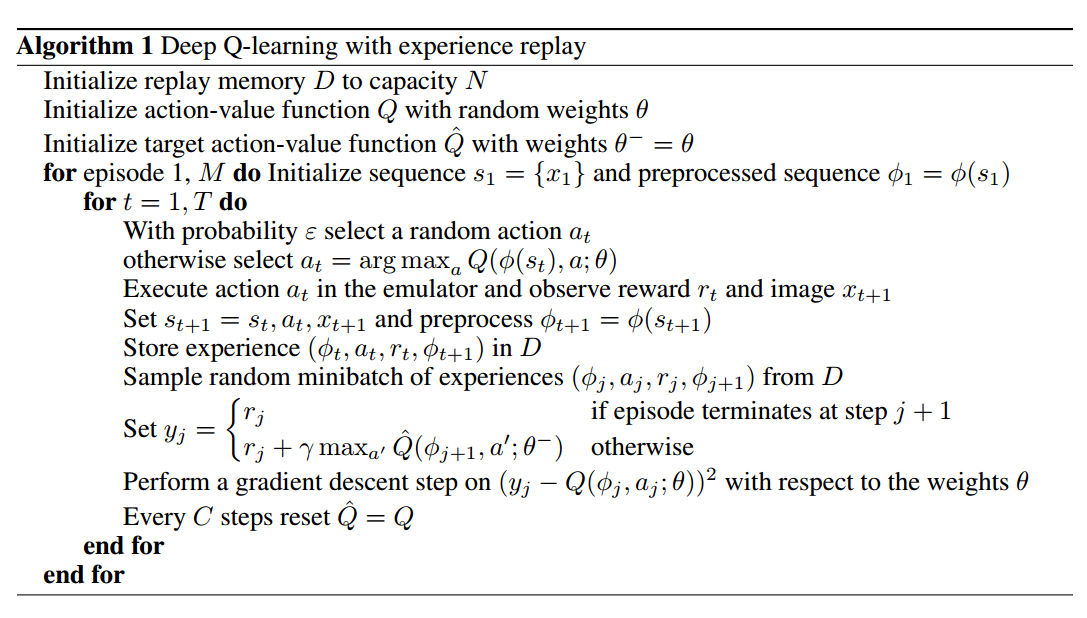

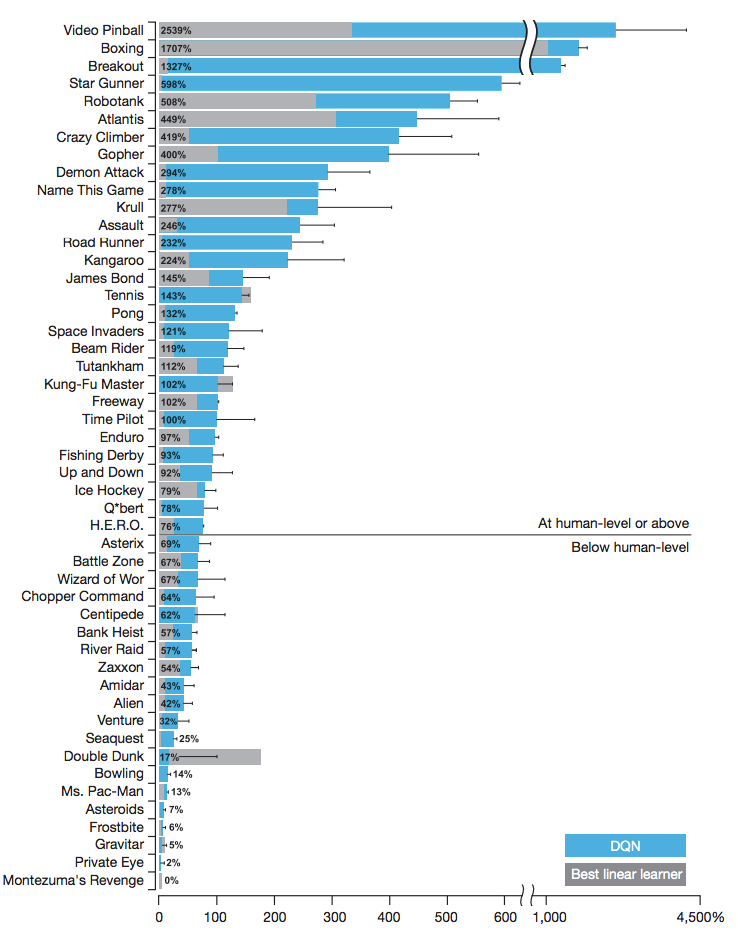

#6 什么是 DQN (Reinforcement Learning 强化学习) 是在优酷播出的教育高清视频,于 上线。视频内容简介今天我们会来说说强化学习中的一种强大武器, Deep Q Network 简称为 DQN Google Deep mind 团队就是靠着这 DQN 使计算机玩电动玩得比我们还厉害 详 首先要解决的问题是如何获取训练样本。在 DQN 中有 Experience Replay 的概念,就是经验回放。即先让agent去探索环境,将经验(记忆)累积到一定程度,再随机抽取出一批样本进行训练。为什么要随机抽取?因为agent去探索环境时采集到的样本是一个时间序列,样本之间具有连续性,如果每次得到样本1)DQN利用深度卷积神经网络逼近值函数。 2)DQN利用了经验回放训练强化学习的学习过程。 我们现在来具体看看这两个方面: 1)DQN的行为值函数是利用神经网络逼近,属于非线性逼近,DQN所用的网络结构是三个卷积层加两个全连接层。用公式表示的话,值函数

Dqn Deep Learning

Dqn是什么

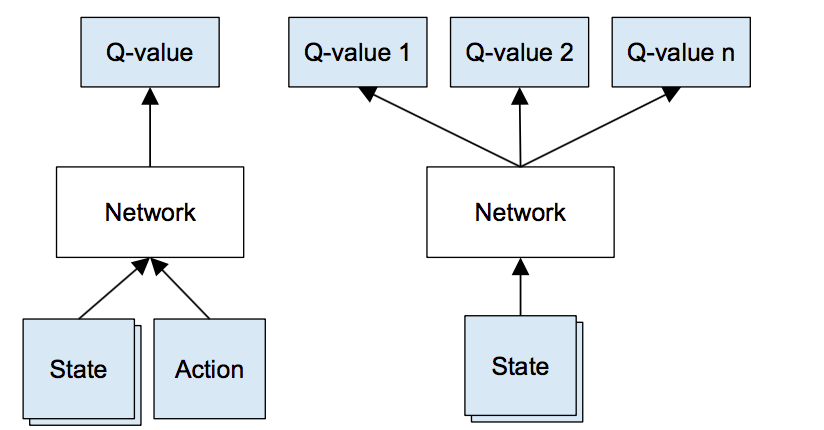

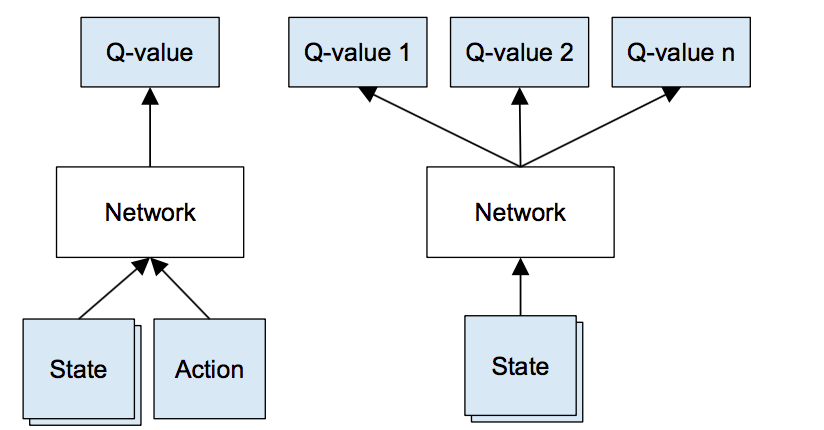

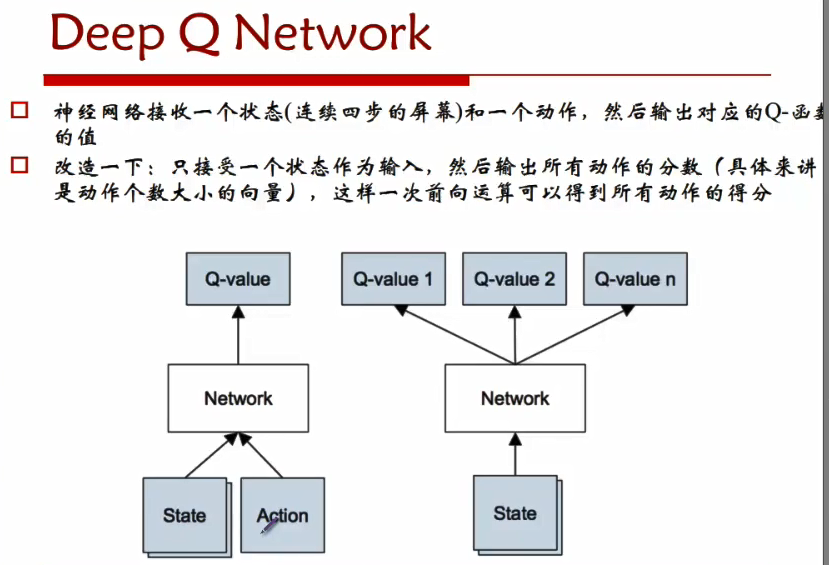

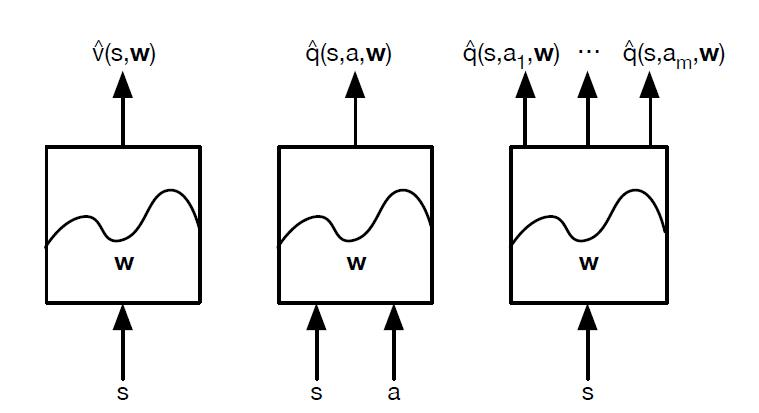

Dqn是什么- 什么是 DQN weixin_的博客 1107 348 粉红色:不会。 黄色:重点。 1为什么要使用神经网络 我们使用表格来存储每一个状态 state, 和在这个 state 每个行为 action 所拥有的 Q 值 而当今问题是在太复杂, 状态可以多到比天上的星星还多(比如下围棋) 如果全用表格来存储它们, 恐怕我们的计算机有再大首先DQN是不收敛的。传统的Qlearning是收敛的。但在使用了非线性的函数逼近如包含任何非线性激活函数的神经网络做函数逼近后,收敛什么的,不存在的。 给定一个策略, 。在一个给定的状态 下, (action value function)可以用来衡量如果我执行策略 ,执行不同的action 分别有多好(多坏)。 纯

Dqn Deep Learning

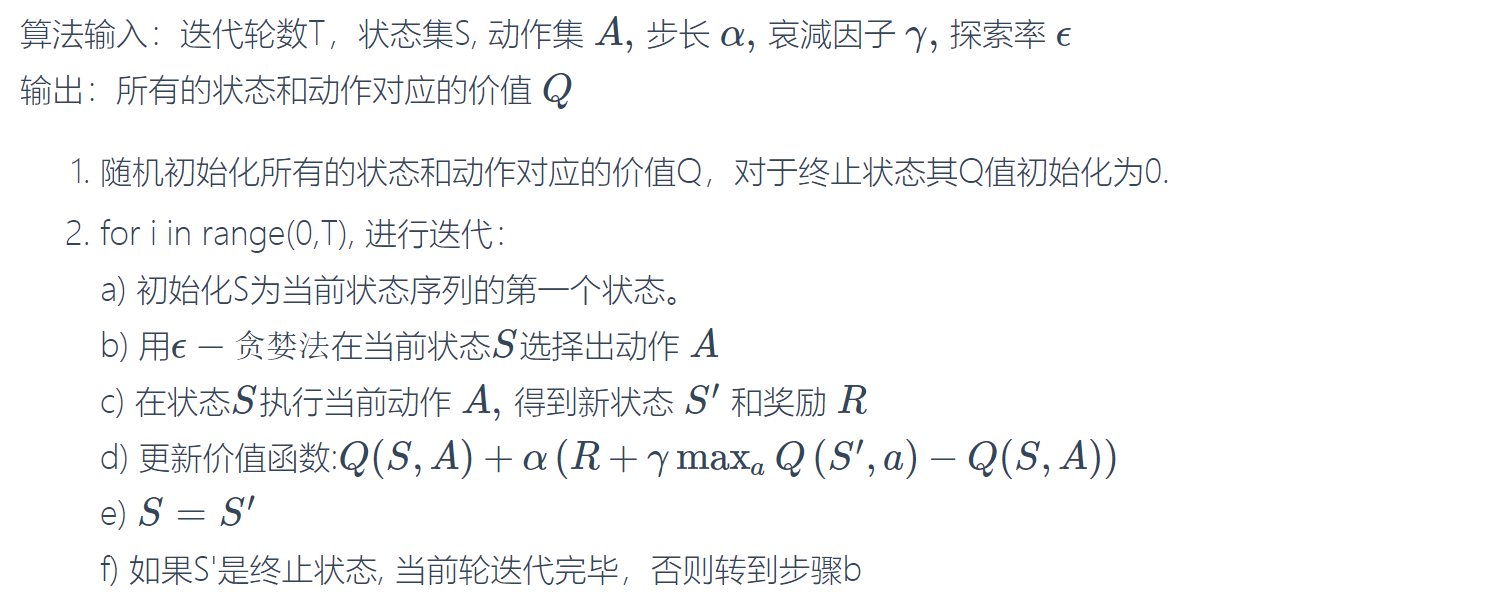

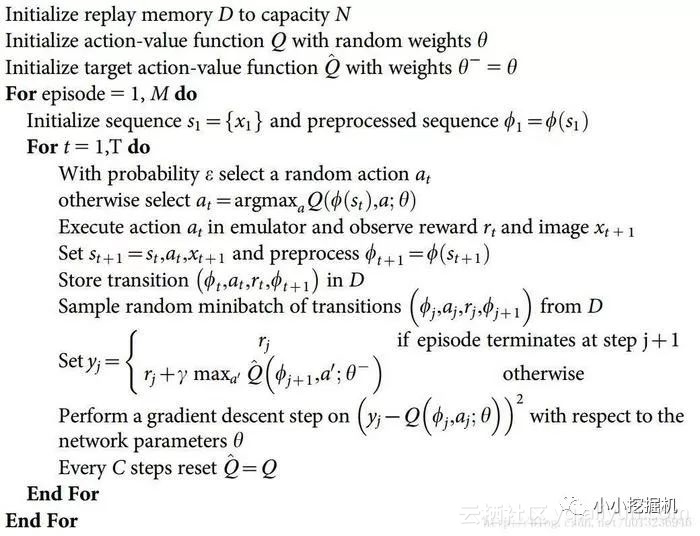

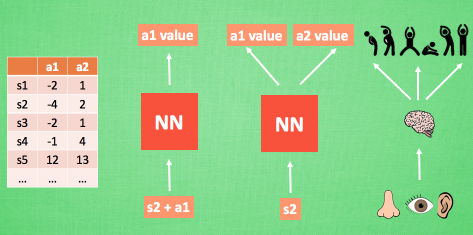

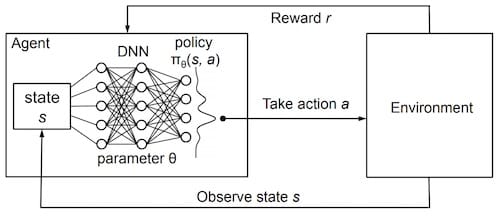

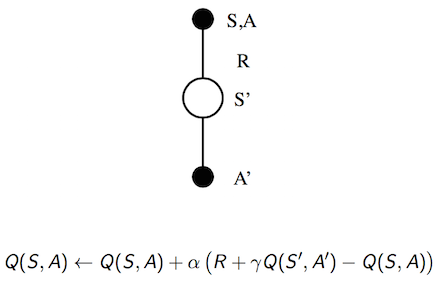

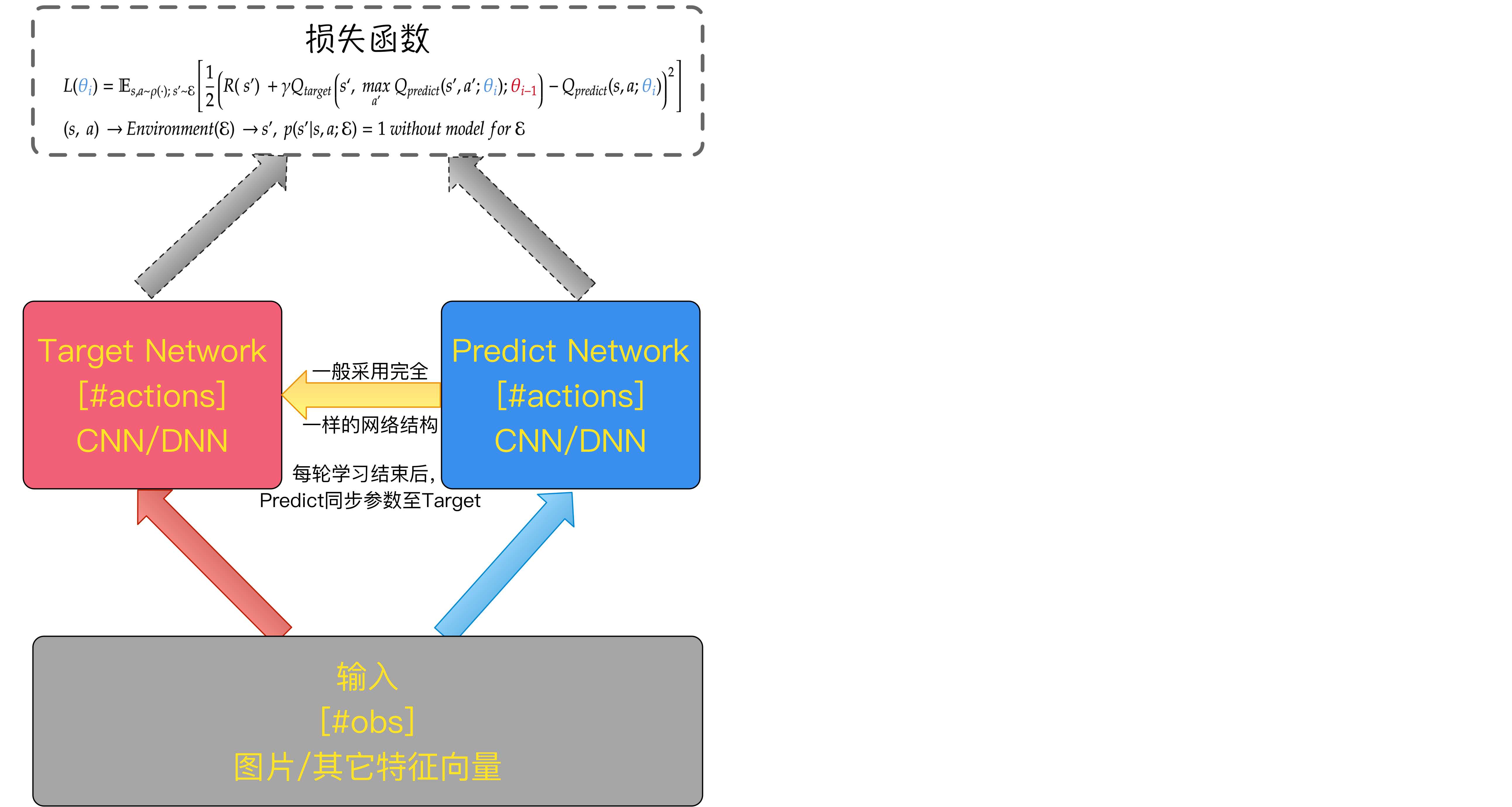

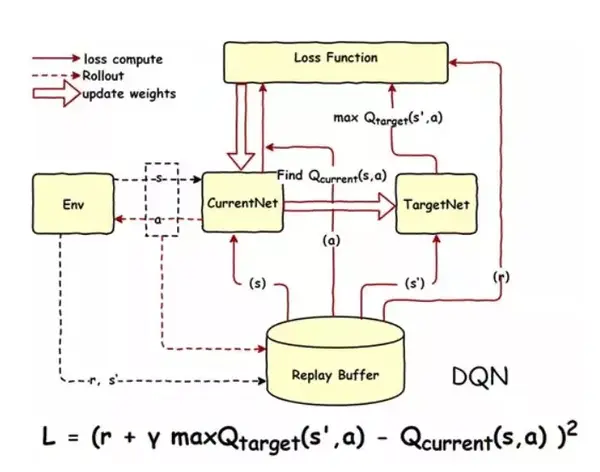

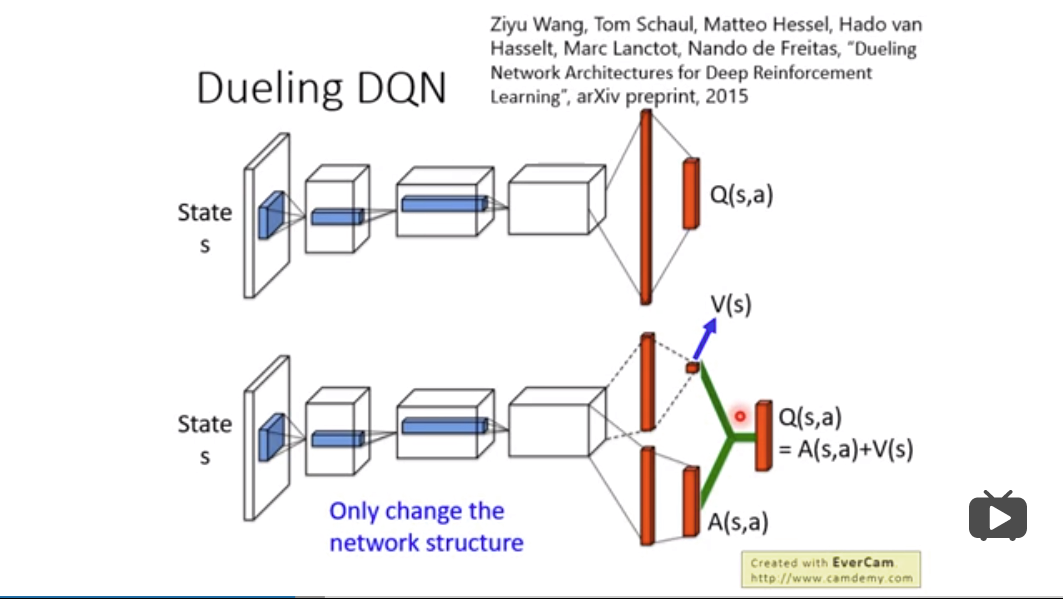

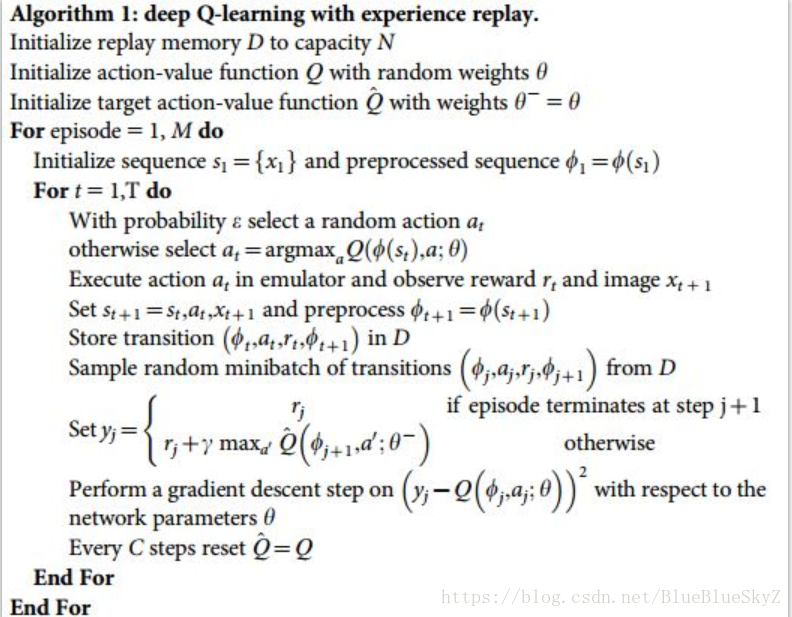

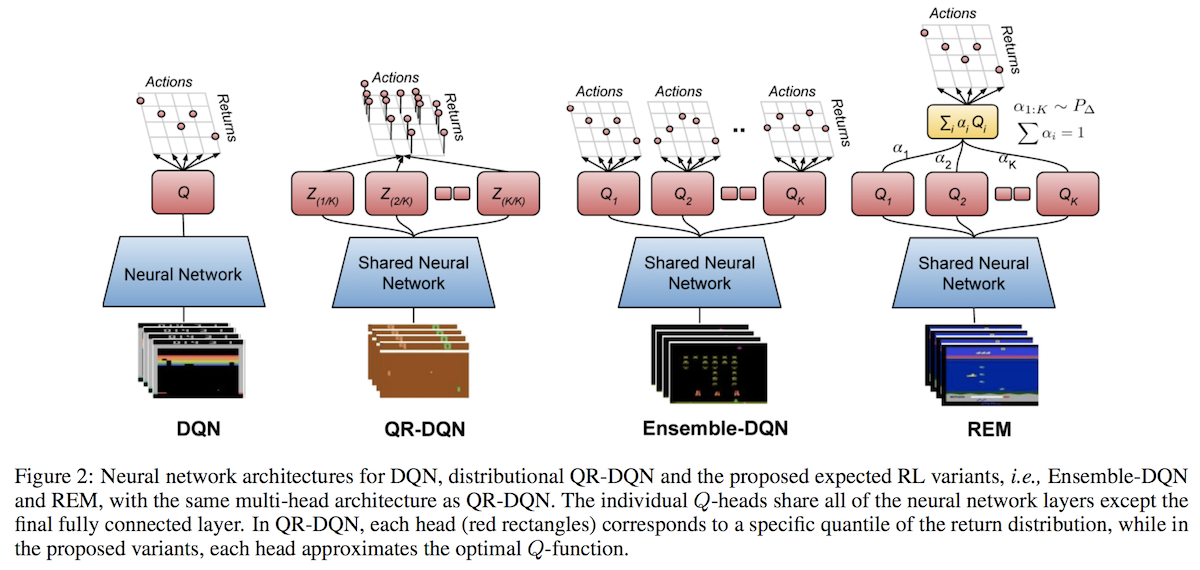

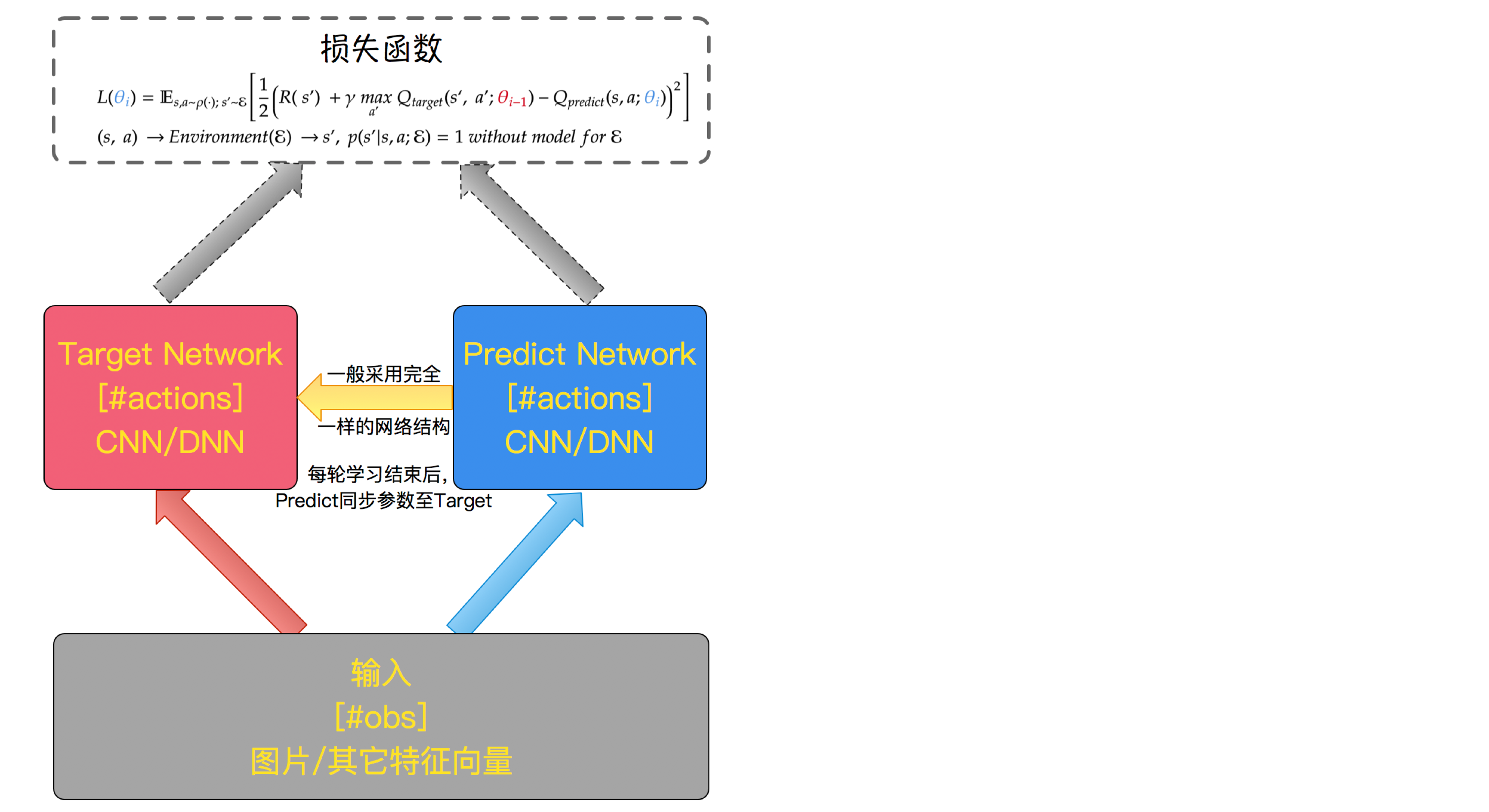

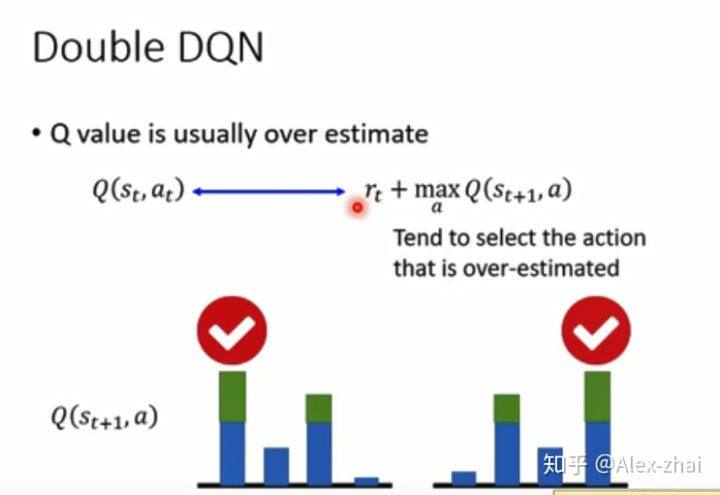

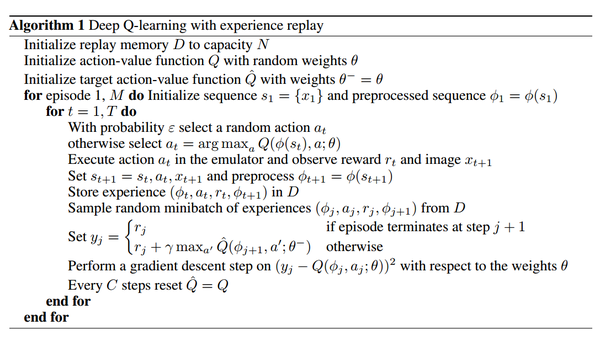

什么是 DQN 今天我们会来说说强化学习中的一种强大武器, Deep Q Network 简称为 DQN Google Deep mind 团队就是靠着这 DQN 使计算机玩电动玩得比我们还厉害 强化学习与神经网络 之前我们所谈论到的强化学习方法都是比较传统的方式, 而如今, 随着机器学习在日常生活中的各种应用, 各种机器学习方法也在 我们简单回顾一下DQN的过程 (这里是15版的DQN): DQN中有两个关键的技术,叫做经验回放和双网络结构。 DQN中的损失函数定义为: 其中,yi也被我们称为qtarget值,而后面的Q (s,a)我们称为qeval值,我们希望qtarget和qeval值越接近越好。 qtarget如何计算呢决斗DQN是什么意思? Emily Weber 通过Doom deathmatch 和Tensorflow改进深度Q学习(教程) $ \ begingroup $ "决斗DQN"中"组合"方程式中的$ a'$是什么意思? (第5页的顶部) $$ Q(s,a;

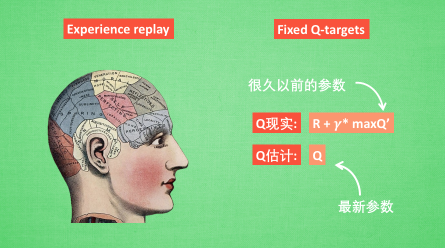

DQN不需要off policy correction,准确的说是Qlearning不需要off policy correction,正是因此,才可以使用replay buffer,prioritized experience等技巧,那么为什么它不需要off policy correction呢? 我们先来看看什么方法需要off policy correction,我举两个例子,分别是nstep Qlearning和offpolicy的REINFORCE,它们作为经典的offpolicy什么是 DQN 粉红色:不会。 黄色:重点。 1为什么要使用神经网络 但是这并不是 DQN 会玩电动的根本原因 还有两大因素支撑着 DQN 使得它变得无比强大 这两大因素就是 Experience replay 和 Fixed Qtargets DQN 两大利器 简单来说, DQN 有一个记忆库用于学习之前的经历 在之前的简介影片中提到 DQN Deep QNetwork 什么是DRL action;

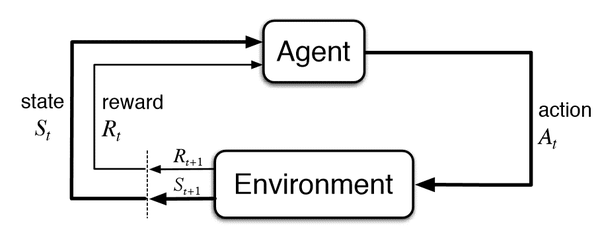

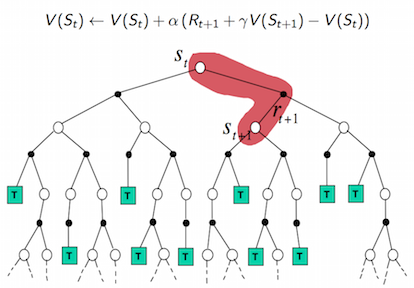

强化学习 Reinforcement learning 中有很多种算法, 都是让机器人一步步学着处理问题, 这次我们说说比较有名的 Q learning详细的文字教程 https//mofanpycom定义将主 DQN 网络的参数复制到目标网络的方法如下: 定义函数 learn (),预测价值函数并更新原始的 DQN 网络: 现在已经在主代码中定义了所有要素,下面构建和训练一个 DQN 网络来玩 Atari 的游戏。 代码中有详细的注释,这主要是之前 Q learning 代码的一个扩展一、Qlearning 强化学习的一个episode: 强化学习的最终目标:当我处于 s t s_t s t 状态,我应该采取从长远来看最好的动作 a t a_t a t 如何实现这个

深度学习与强化学习的两大联姻 Dqn与ddpg的对比分析 电子创新网imgtec 社区

用keras 搭建double Dqn 模型 Steemit

冰柔是什么 意思 阻截是 是什么意思 庆王坟是什么意思 因缘际会是什么意思 银杏洋参胶囊是什么意思 湿地生态文化是什么意思 dqn 怎么组词 有关dqn的谜语 汉语词典收录了近50万个词语,包含词语的解释、例句和翻译,词库仍在不断更新中。 词典数据主要来源于新华字典,以及通过机器学习从今天我们会来说说强化学习中的一种强大武器, Deep Q Network 简称为 DQN Google Deep mind 团队就是靠着这 DQN 使计算机玩电动玩得比我们还厉害 之前我们所谈论到的强化学习方法都是比较传统的方式, 而如今, 随着机器学习在日常生活中的各种应用, 各种机器学习方法也在融汇, 合并, 升级 chaos;head男主角口中的dqn是什么意思? chaos;head男主角口中的dqn是什么意思? 展开 我来答 1个回答 #热议# 什么时候你体会到过学历的重要性? dufljd7 推荐于 ta获得超过22个赞 知道小有建树答主 回答量: 18 采纳率: 100% 帮助的人: 131万 我也去答题 访问个人页 关注 展开全部 dqn

Dqn是什么 专业体育投注网站

李宏毅 Atdl Drl Lecture 4 Hackmd

什么是 DQN (Reinforcement Learning 强化学习) 简介 DQN——Deep Qlearning。在上一篇博客DQN(Deep Qlearning)入门教程(四)之Qlearning Play Flappy Bird 中,我们使用QTable来储存state与action之间的q值,那么这样有什么不足呢? 我们可以将问题的稍微复杂化一点了,如果在环境中,State很多,然后Agent的动作也很多,那么毋庸置疑Qtable将会变得很大很大简单来说, DQN 有一个记忆库用于学习之前的经历 在之前的简介影片中提到过, Q learning 是一种 offpolicy 离线学习法, 它能学习当前经历着的, 也能学习过去经历过的, 甚至是学习别人的经历 所以每次 DQN 更新的时候, 我们都可以随机抽取一些之前的经历进行学习

深度强化学习 Machine Learning Notes

Dqn算法原理及应用 实现atari游戏

DQN 两大利器 ¶ 简单来说, DQN 有一个记忆库用于学习之前的经历 在之前的简介影片中提到过, Q learning 是一种 offpolicy 离线学习法, 它能学习当前经历着的, 也能学习过去经历过的, 甚至是 强化学习:(四)Qlearning, DQN, DDQN是什么? 时间 21/8/5 ; 简述时间差分算法 介绍QLearning DQN 算法 基本原理 DQN的两个关键trick分别是什么? DQN 都有哪些变种?DQN有哪些改进方向? 引入状态奖励的是哪种DQN? Dueling DQN和DQN有什么区别? 介绍OpenAI用的PPO算法 介绍TRPO算法 为什么TRPO能保证新策略的回报函数单调不减?

强化学习 Reinforcement Learning 中的q Learning Dqn 面试看这篇就够了

强化学习12 什么是dqn 简书

\ theta,\ alpha,\ beta)= V(s;\ theta,\ alpha)\ frac {1} {N} \ sum_ {a'} ^ {N} A(s,a';这篇文章是 TensorFlow Tutorial 入门教程的第八篇文章。 实现DQN(Deep QLearning Network)算法,代码90行 MountainCar 简介 上一篇文章TensorFlow (七) 强化学习 QLearning 玩转 OpenAI gym介绍了如何用**Q表(QTable)**,来更新策略,使小车顺利达到山顶,整个代码只有50行。 我们先回顾一下上一篇文章的要点。

强化学习12 什么是dqn 简书

Dqn Deep Q Learning 入门教程 四 之q Learning Play Flappy Bird 段小辉 博客园

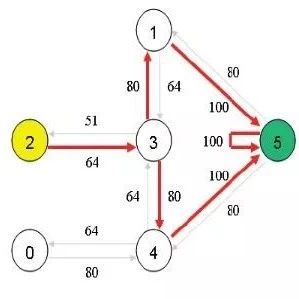

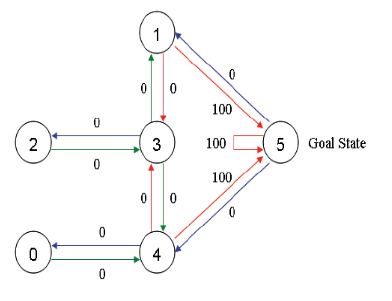

强化学习 12 什么是 DQN 转到我的清单 专栏首页 杨熹的专栏 强化学习 12 什么是 DQN 强化学习 12 什么是 DQN 阅读 469 0 前面我们有一篇文章介绍了 q learning, 也用 Deep Q Network 做了一个小游戏, 但是还没有详细的讲DQN的理论,今天我们就来看一下它的概念。 当状态空间 提示:转载请注明出处,若文本无意侵犯到您的合法权益,请及时与作者联系。进阶阶段(一)DQN算法入门前言 一、pandas是什么? 二、使用步骤 1引入库 2读入数据 总结前言提示:这里可以添加本文要记录的大概内容:例如:随着人工智能的不断发展,机器学习这门技术也越来越重要,很 上一篇讲了什么是 DQN,今天来看看如何用代码实现: 算法来自:Volodymyr Mnih, Playing Atari with Deep Reinforcement Learning 根据下面这个图看代码会更容易理解: 图片来自: Resource Management with Deep Reinforcement Learning 1 首先我们需要建立一个 DQN agent: import gym from

强化学习之dqn进阶的三大法宝 Pytorch Ton的博客 程序员宅基地 程序员宅基地

深度强化学习5 Deep Q Learning Dqn 华为云

\ theta,\ beta) \ biggl(A(s,a;0 前言如果说DQN从入门到放弃的前四篇是开胃菜的话,那么本篇文章就是主菜了。所以,等吃完主菜再 放弃吧!1 详解QLearning在上一篇文章 DQN从入门到放弃 第四篇中,我们分析了动态规划Dynamic Programming并且由怎么解决的呢?让我们走进dqn,一探究竟。 cnn实现q(s, a) 如果我们以纯数学的角度来看动作值函数 ,不过就是建立一个从状态空间 到动作空间 的映射,而映射的具体形式是什么,完全可以自己定,只要能够接近真实的最优 就是胜利。于是用cnn完成这种映射的

什么是dqn 强化学习 知乎

实战深度强化学习dqn 理论和实践 阿里云开发者社区

dq是犯规的意思。在wwe中有很多比赛不允许选手使用武器或者是击打选手下体或者是场外选手捣乱。如果犯规了,就要被判dq而输掉比赛。当然,无dq比赛除外。 资料拓展: 香港话: 粤语的一种,源自粤语广府片的广州话,与广州话高度接近。为中国香港特别 什么是Dueling DQN呢?看下面的图片 上面是我们传统的DQN,下面是我们的Dueling DQN。在原始的DQN中,神经网络直接输出的是每种动作的 Q值, 而 Dueling DQN 每个动作的Q值,是由状态价值V和优势函数A确定的,即Q = V A。 什么是优势函数?我们可以简单理解为,对于一个特定的状态,采取一个动作所能什么是 DQN (Reinforcement Learning 强化学习) 19 什么是 Actor Critic (Reinforcement Learning 强化学习) 莫烦Python 8162 播放 28 弹幕 DQN只狼实战教程手把手带你实现用强化学习DQN打只狼里的boss(第一期) 蓝魔digital 8529 播放 9 弹幕 数之道 08走进"卷积神经网络",了解图像识别背后的原理 FunInCode 16

强化学习之路 清华博士后解读篇文献 万字长文总结 腾讯新闻

Dqn Deep Q Learning 入门教程 一 之强化学习介绍 段小辉 博客园

什么是dqn 强化学习 知乎

深度强化学习介绍 Ppt Human Level Control Through Deep Reinforcement Learning Dqn

主流强化学习算法论文综述 Dqn Ddpg Trpo A3c Ppo Sac Td3 深度强化学习实验室

6 Dqn Deep Q Network Double Dqn Dueling Dqn 程序员大本营

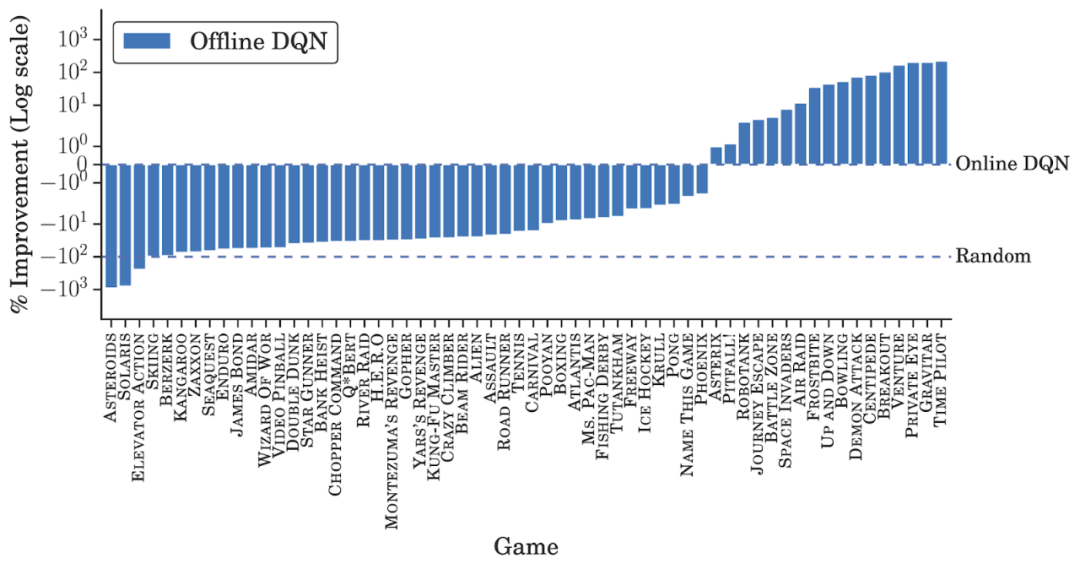

谁说rl智能体只能在线训练 谷歌发布离线强化学习新范式 训练集相当于0多个imagenet 谷歌 强化学习 数据集 新浪科技 新浪网

Tensorflow 2 0 八 强化学习dqn 玩转gym Mountain Car 极客兔兔

强化学习 Dqn算法原理详解 Wanjun S Blog

Dqn是什么意思 Dqn的全称 在线英文缩略词查询

强化学习 3 Dqn 吱吱了了 博客园

Ddqn 无偏估计版dqn 飞桨ai Studio 人工智能学习实训社区

深度学习与强化学习的两大联姻 Dqn与ddpg的对比分析 Segmentfault 思否

如何选择深度强化学习算法 Muzero Sac Ppo Td3 Ddpg Dqn 等 已完成 深度强化学习实验室

深度 超越dqn和a3c 深度强化学习领域近期新进展概览 机器之心 微信公众号文章阅读 Wemp

强化学习笔记 五 函数近似方法 零一人生

深度强化学习 Dqn 初探 Qcloud Kid的博客 Csdn博客

Deep Q Learning 系列论文漫谈 一 从q Learning到dqn Our Home

深度强化学习5 Deep Q Learning Dqn 华为云

让ai 玩我们的童年游戏 七鬼五二三 开发者头条

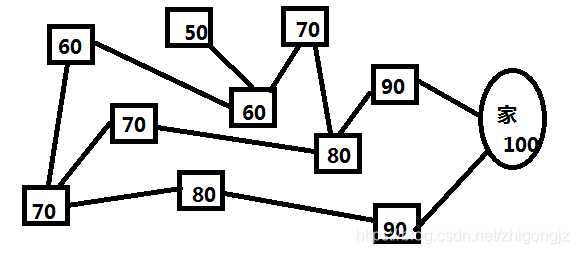

白话dqn Deepq Learning 强化学习算法 五子棋九宫格对弈实例 Zhigongjz的博客 程序员宅基地 程序员宅基地

强化学习 Dqn 算法改进 Debugger Wiki Debugger Wiki

Dqn 意思深度強化學習 百度百科 Tbtky

什么是dqn Reinforcement Learning 强化学习 Youtube

Dqn Deep Learning

强化学习7日打卡营 Sasar Q Learning Dqn 码农家园

强化学习 三 Deep Q Network Dqn 算法

深度强化学习 Machine Learning Notes

强化学习 Dqn算法原理详解 Wanjun S Blog

機器學習ml Note Reinforcement Learning 強化學習 Dqn原理 By Ggwithrabitlife 雞雞與兔兔的工程世界 Medium

强化学习 十 Dqn的理解 知乎

学习dqn Deep Q Learning Network 冰蓝记录思考的地方

强化学习7 一文详解dqn 算法

Dqn算法原理及应用 实现atari游戏

转载 强化学习 九 Deep Q Learning进阶之nature Dqn 豌豆ip代理

4 6 Prioritized Experience Replay Dqn

改进后的dqn是什么样的 知乎

Learning From Data Dqn Wlsdzyzl

强化学习 Dqn算法原理详解 Wanjun S Blog

强化学习扫盲贴 从q Learning到dqn 专知

Dqn和ddpg深度强化学习的2个算法 Python教程网

看alphago虐柯洁不爽 那就解剖它亲哥 集智俱乐部 财新博客 新世纪的常识传播者 财新网

Deep Q Learning 系列论文漫谈 二 从target Net和experience Replay聊起 Our Home

强化学习简介 三 Dqn 桂糊涂的博客

学习dqn Deep Q Learning Network 冰蓝记录思考的地方

强化学习dqn及其变体原理与parl实现 飞桨ai Studio 人工智能学习实训社区

Deep Reinforcement Learning For Online Advertising In Recommender Systems 阅读笔记 随风而行的个人博客

什么是dqn 强化学习 知乎

强化学习之dqn进阶的三大法宝 Pytorch Ton的博客 程序员宅基地 程序员宅基地

深度强化学习之深度q网络dqn详解 知乎

4 7 Dueling Dqn

强化学习 Dqn算法原理详解 Wanjun S Blog

李宏毅 Atdl Drl Lecture 4 Hackmd

强化学习 从q Learning到dqn到底发生了什么 知乎

用强化学习制作游戏ai Talk Is Cheap Show Me The Code Csdn博客

Dqn Deep Q Learning 入门教程 六 之dqn Play Flappy Bird Mountaincar 段小辉 博客园

什么是dqn 强化学习 Reinforcement Learning 莫烦python

离线强化学习 马亿的博客 My Blog

Dqn是什么梗dqn出处是哪儿 一聚教程网

Dqn与pg多角度比较

Deep Reinforcement Learning For Online Advertising In Recommender Systems 阅读笔记 随风而行的个人博客

Ddqn 无偏估计版dqn 飞桨ai Studio 人工智能学习实训社区

李宏毅深度强化学习课程 Deep Q Learning Advanced Tips Infoq

深度强化学习之 Dqn训练超级玛丽闯关 Myencyclopedia 中文站

深度强化学习 Machine Learning Notes

强化学习 四 Dqn系列 Dqn Nature Dqn Ddqn Dueling Dqn等 微笑sun 博客园

强化学习 从q Learning到dqn到底发生了什么 知乎

Dqn起源 原理 核心理解 Charel Chen的博客 Csdn博客

强化学习 Deep Q Network Dqn 算法详解 Shura的技术空间 Csdn博客

学习dqn Deep Q Learning Network 冰蓝记录思考的地方

强化学习简介 三 Dqn 桂糊涂的博客

Dqn 搜索结果 哔哩哔哩 Bilibili

深度强化学习专栏 2 手撕dqn算法实现cartpole控制 古月居

Pytorch教程 Dqn 强化学习 Wx60dbf19c5ac61的博客 51cto博客

Dqn 思维决策 强化学习 Reinforcement Learning 莫烦python

Dqn和ddpg深度强化学习的2个算法 Python教程网

深度学习与强化学习的两大联姻 Dqn与ddpg的对比分析 电子创新网imgtec 社区

强化学习 从q Learning到dqn到底发生了什么 知乎

深度强化学习5 Deep Q Learning Dqn 华为云

Deep Q Learning 系列论文漫谈 一 从q Learning到dqn Our Home

Ctafi9t2hsowdm

五 强化学习 写给人类的机器学习

Dqn算法在最大奖励处收敛的问题 深度强化学习实验室

强化学习 从q Learning到dqn到底发生了什么 知乎

转载 强化学习系列之九 Deep Q Network Dqn Zhang Rong

Dqn 的算法思想和代码实现 简书

0 件のコメント:

コメントを投稿